さくらインターネット #石狩DC 体験記

はい、行ってまいりました。さくらのDC@石狩。

ブログを書くまでが #石狩DC ということで、記憶がフレッシュなうちにまとめます。

謝辞

はじめに今回貴重な機会をいただきまして、さくらインターネット並びにはてなの担当者さま方に感謝申し上げます。

単に新しい/珍しいだけじゃなく、多くのレイヤーでさくらスタッフの皆様が "考えて動いて" いることを実感できるとても良いツアーでした。

インフラに関心がある人もまだない人もコレを見ずしては死ねないと思いました。

私なりに今回得てきたものをとりまとめて、今回のツアーを締めくくりたいと思います。

巡ってきたところ

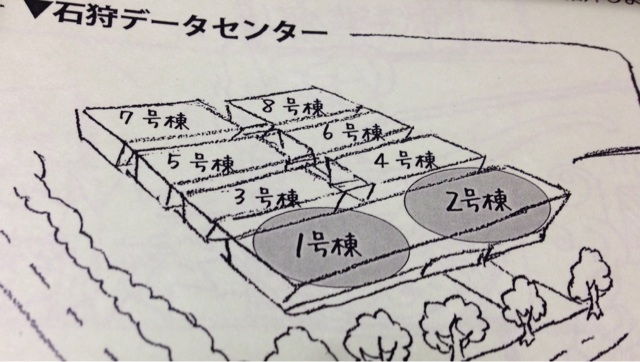

今回拝見した棟

図の通り、2年前に開所した1号棟に続き、まもなくオープンする2号棟にもおじゃましてきました。

空調設備

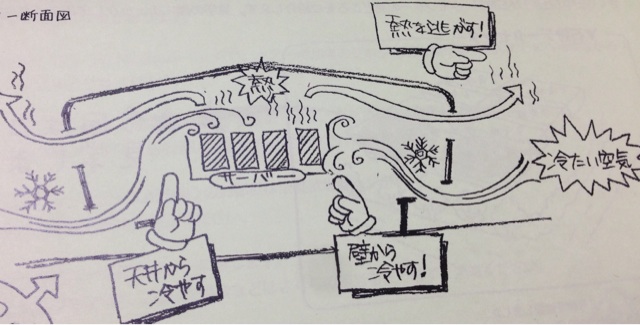

このデータセンター、各所で報じられている通り空調に外気を取り込む仕組みが採用されており、実際にその設備の中身津々浦々を余すところなく見学出来ました。

フィルタ

右の綿のようなものが手前のフィルタで大きめのホコリやらを防ぐ層、左が除塩フィルタで、先ほどのフェンスを抜けてきた空気はここからミキシングチャンバーに取り込まれます。

ミキシングチャンバー

写真はミキシングチャンバーの床にある吸気口で、ここの開き具合で外気をどの程度取り込むか調整できるようになっています。

ミキシングチャンバーはその名の通りサーバから排気された熱を外気と混ぜて適切な気温/湿度を作り出す部分で、季節に応じて取り込み具合を調整してサーバルーム内部に取り込む空気を作りだしている部分です。

見落としがちなのが加湿で、乾燥し過ぎると静電気が発生して機器がやられたりする点は要注意。

温度も低ければいいというものではない、というのはだいぶ前にこちらのエントリで挙げられていたとおり、この辺はさくら独自の制御プログラムでまかなっている様子でした。ゴイスー

その他

冬場は降雪対策としてサーバからでた余剰の熱でロードヒーティングしたり、更には床暖房にも利用しているとのことで、至る所で熱効率が考えられた構成になっていました。

サーバルーム

吸排気の部分もさることながらサーバルームも開所から2年の間の進化が見て取れ、時間も予算もかかる設備周りもどんどんチャレンジしている姿勢が伝わるものでした。

全体的な特徴

一般的なデータセンターでは床を上げて、その空間を利用して配線したり冷気を送るようにしているところ、石狩DCでは床を上げずに配線は天井を利用し、冷気は壁or天井吹き出し方式を採用している点は他と異なる特徴かなと思います。

"冷気は上から下に、熱気は下から上に" という一般的な原理原則に沿ったやり方になっているなという印象です。

各ラックのフロント、リア、上部には温度センサーが付けられていて、全ラックの温度状況を一覧できるような仕組みが実装されていたのも大きな特徴かと思います。

さすがにここまで細かく計測しているDCは多くないのではと思います。

この辺りまで細かく見ているからこそ、後述のようにエアフローを変えて実際に検証して効果を測れるのだろうと。

更に、建物自体が2階建てと高さを取らず、面積を広く取る設計になっているため、動荷重はそれほど問題にならずラックにものをビシッと詰めてもOKとのこと。

後述の電源状況とあわせても、都心のDCではできないような高密度な設計ができそうで夢が広がるポイントですね。

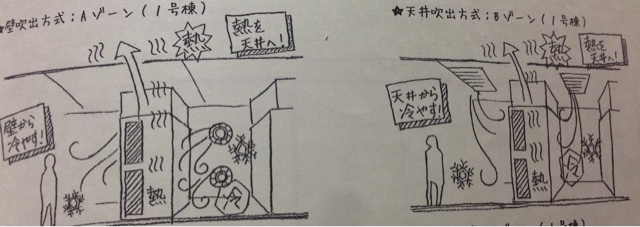

Aゾーン/Bゾーン

AゾーンとBゾーンではラック上部にファンとダクトが付けられており、フロア全体に冷気を行き渡らせ、ラック上部で吸気する形になっていました。

正直なところ、ラックごとにダクトを付けるやり方だとダクト部分とそこに搭載するファンが特注っぽくなってコスト高な上にラック上部のサーバに熱がたまるんじゃないかなという印象でした。

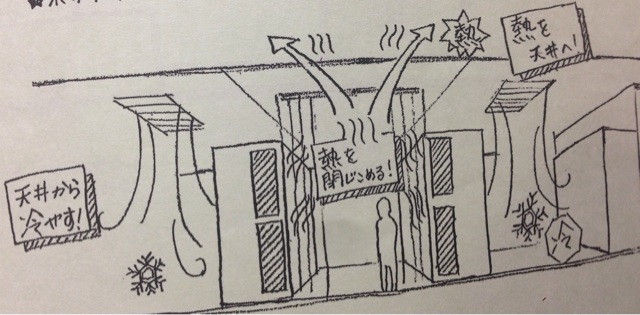

Cゾーン

一方Cゾーンでは各ラックにダクトを付けるのではなく、熱気を囲い込んで天井につけた大きなファンで排気する方式に変わっていました。

他のデータセンターでも最近のフロアではよく見るアイルキャッピングのような感じです。

10月の記事で触れられている通り、実際に方式を変えて試した結果この方式に落ち着いたようです。

これからサーバルームが作られる予定の2号棟もこの方式で作っていくということなので、空調効率はA/Bゾーンの方式よりもCの方式のほうがアドバンテージが大きいということが伺えます。

余談ですが新しいサーバルームの電源やらの検証のために、ラックにたくさんのドライヤーを吊るしていたのが印象的でした。

確かにサーバとドライヤーは近いものがある。。(多くの電気を食って熱を吐く的な意味で)

電源設備

見学したところの話

普段はコンセントバーやサーバの電源モジュールくらいしか馴染みがないので、高圧電気室や発電機室はいろいろと圧巻でした。

特に圧巻なのはズラリと並ぶディーゼル発電機。

機関車の車庫みたいな絵面。。

こういう大きなディーゼル発電機は都心のデータセンターでは騒音や重量の問題で利用されず、ガスタービン発電機が採用されることが一般的ですが、さすが広大な石狩の土地を活かした展開だなと。

ラックあたりの標準提供電源容量も大きく、8kVA(最大15kVA)と、都心のDC比で2倍~3倍も供給可能というふとっぱら。

この設計もSandyBridge時代の設計で、IvyBridgeに変えたら3割くらい消費電力が下がってくるケースもあるため、石狩DCは他ではあまり見られない "電気余り" な状況とのこと。

ここまで来るとラックあたりをもっと高密度にしたくなってくるわけですが、そこは先ほどのラック周りで述べたとおり、ラックも床面も十分な耐荷重なので思い切って詰めても大丈夫そう。

一部フロアでは直流送電の設備が置かれており、一般的な100Vではなく、230Vで送電していました。

230Vでの電源供給については自分も以前検討したことがあり、電源設備の都合上コスト高になる&ネットワーク機器が対応していないものが多いため断念した過去があります。

石狩DCでは "それ用" に設計されているところが自社ですべてやれる利点を活かせているなと感じます。

先の空調の話と合わせて、見学で回った際に見たPUEは1.08と、世界的にもトップクラスの電源効率をたたき出していました。

更に聞いた将来の話

石狩DCのパンフレットにも書いてあるのですが、近く石狩DCの近所に太陽光発電所を作る計画があるそうです。

そこから超電導直流送電技術を使って電圧変換を一切使わずにDC内の電源設備まで電気を供給するような実証試験を行うということで、更にエコな世界に行きそうな気配です。

広大な土地に多くの給電方法が合わさることで、通常ではできないようなラック構成ができたり、電力調達の効率が上がってサービスが良くなったりしていくことを期待しております。

ネットワーク

石狩 <-> 東京のレイテンシはだいたい10ms強で、50ms or die.的な観点からは結構大きいレイテンシですが、通常のWebサービスでは無視できる向きもあるのではと思います。

冗長構成については、実際現地で説明を聞いて、他の地方にはさほど引けをとらない良環境であることも改めて確認できました。

インターネット回線

さくらインターネットはバックボーンの接続状況を自社のサイトで公開しているので詳しい話はこのへんを見ていただくとして、このページにはない回線としてOCN北海道の回線が入っているとのこと。

また、今後更に接続キャリアを増やす予定もあるようなので、インターネット回線の対障害性は向上していく方向のよう。

個人的に気になったのは、現地の回線を使っても石狩DCへの通信が東京経由になるケースがあったりすること。

一見物理的に近いように見えても、実は遠回りしてしまうと思ったようなレイテンシが出ないので、このあたりは今後自分が選定する場合の注意点として覚えておきたいところです。

DC内部の回線

DC内部の回線が切れるようなことが発生すると復旧に時間もかかるため、うかつにクロスしていたりするところでファイバーカットが起こったりすると深刻な障害になり、サービスが受けるダメージたるや考えるとお腹痛くなってきます。。

石狩DCはMDF室が2つあり、それぞれ違う経路で地下埋設した回線を引き込み、構内ではそれぞれの回線がクロスすることがないように設置されている頼もしい構成でした。

自分で回線を引く設計をする際にはゆめゆめ気をつけたいポイントですね。。

サービス運用周り

サーバ本体へのオペレーションの効率/安全性の追求

自社サービスで、サーバの役割が把握出来ているならオペレータの判断で作業を進めてもいいかもしれませんが、顧客にサーバを提供している場合この作業には一層の注意が求められることは想像にかたくありません。

IPMI全盛の時代でも、最後の最後はサーバの目の前でないとできない作業が発生することはなくなりません。

声出しや指差しはよくある確認方法ですが、今回紹介されたオペレーションの中で興味をひかれたのは、テレカンのシステムを使った遠隔地でのダブルチェック体制でした。

現地のスタッフ以外でも対応可能なように範囲を広げれば、ダブルチェック体制を保ちやすいという良いインプットを得られました。

スタッフの意見で設備改善

搬入経路の非効率なところや、規模の拡大に伴ってスケールしにくいところは新たな棟で積極的に潰している点はフットワーク軽くとても良いと思った点です。

一気に全部の建物を作らずに、モジュール化を進めるやり方を採用している利点を最大限活かした作りになっていました。

残りの6棟がどこまで進化していくか、今後もウォッチし続けたいところです。

ほかにも

試される大地の試されるデータセンター

さくらインターネットの石狩DCは、固定化されたオペレーションを淡々とこなす場所ではなく、常にチャレンジングな取り組みを続けるエッジの効いたテクノロジーの塊でした。

帰りの道すがらでさくらのスタッフさんが「今後規模が大きくなるにしたがって、単に人を多くするだけでは回らなくなるのでここから先さらに技術開発が必要になる」といったことを言っていたので、まだまだ進化していく余地が沢山ありそうで残り6棟がどのように進化していくのかとても楽しみです。

田中社長の話

以前モリスさんが書いていたけども、すごい方でした。

技術的な話については↑のエントリに譲るとして、それ以外にも驚かされたことが幾つかあります。

1日目の懇親会で話した時は、商売的/営業的なことについて話をしてもそんじょそこらの営業よりよどみなく話していて、さすがと思っていた。

思っていたら2日目のオプショナルツアーであちこち回っていた時には石狩や周辺地域の歴史的な話や地元の産業、さらにはそれら地場産業と石狩DCの関係についても自身の言葉で誰かにフォローされることなく話をしており、真の意味で上から下まで深く理解している段違いの方であることがよく理解できました。

さくらインターネット伝説は伊達じゃない。

おわりに

石狩DCツアーは、普段データセンターに馴染みのある人はもちろん、ない人ほど得られるものが多い素晴らしいイベントになるだろうと感じてます。

次回がもしあるようであれば、普段ソフトウェア周りをやっている人、AWSのようなIaaSがメインだという方も臆せず応募することを薦めます。

エンジニアとして、見ずして過ごすのはもったいないのでこういう機会が広まるとよいなと願っております。

重ねて、田中社長はじめさくらインターネットの皆様、並びにはてなの担当者様に感謝申し上げて私の #石狩DC を締めさせていただきます。

ありがとうございました。